Почему стоит выбрать локальные LLM для программирования?

Локальные модели больших языков (LLM) для программирования стали настоящим прорывом в мире разработки. Они позволяют разработчикам работать с продвинутыми инструментами генерации кода и помощи, не выходя из своего устройства. Рассмотрим, какие преимущества предоставляет использование локальных LLM и как они могут улучшить ваш рабочий процесс.

- Улучшенная конфиденциальность: Ваш код остается на вашем устройстве, что исключает риски утечек информации.

- Офлайн-доступ: Вы можете работать в любом месте и в любое время, без необходимости подключения к интернету.

- Отсутствие постоянных расходов: Один раз настроив аппаратное обеспечение, вы избегаете дополнительных затрат.

- Настраиваемая производительность: Вы можете адаптировать работу модели под свои нужды и рабочий процесс.

Топ локальных LLM для программирования (2025)

На сегодняшний день существует множество локальных LLM, подходящих для программирования. Рассмотрим некоторые из них, которые выделяются своими характеристиками и применимостью.

Code Llama 70B

Для запуска этой модели потребуется от 40 до 80 ГБ видеопамяти, но с учетом квантизации можно обойтись и всего 12-24 ГБ. Эта модель отлично справляется с языками Python, C++ и Java, что делает её идеальной для профессиональной разработки и масштабных проектов.

DeepSeek-Coder

С потреблением 24-48 ГБ оперативной памяти (или 12-16 ГБ в квантизированных версиях), эта модель поддерживает множество языков и отличается высокой скоростью работы. Она отлично подходит для сложного программирования и профессиональных задач.

StarCoder2

Эта модель требует от 8 до 24 ГБ видеопамяти, в зависимости от размера. StarCoder2 хорошо подходит для сценариев и имеет активное сообщество поддержки, что облегчает её использование для общего программирования и исследовательской деятельности.

Qwen 2.5 Coder

С потреблением 12-16 ГБ для модели 14B и 24 ГБ для более крупных версий, Qwen 2.5 Coder демонстрирует многоязычные возможности и эффективен в выполнении задач. Она идеально подходит для легких и многоязычных программ.

Phi-3 Mini

Эта модель с требуемой видеопамятью всего 4-8 ГБ является отличным выбором для тех, кто работает на минимальном оборудовании. Phi-3 Mini обладает хорошими логическими способностями и подходит для простых задач.

Другие заметные модели для локальной генерации кода

Не стоит забывать о других моделях, таких как Llama 3, известная своей универсальностью в работе с текстом и кодом, и GLM-4-32B, которая выделяется высокой производительностью в области анализа кода. Модель aiXcoder также заслуживает упоминания благодаря своей легкости в запуске и удобству для завершения кода на Python и Java.

Аппаратные требования

При выборе модели важно учитывать требования к аппаратному обеспечению. Высокопроизводительные модели, такие как Code Llama 70B и DeepSeek-Coder, требуют более 40 ГБ видеопамяти для работы на полную мощность, тогда как модели среднего уровня, как StarCoder2 и Qwen 2.5, могут работать на видеокартах с 12-24 ГБ. Легкие модели, такие как Phi-3 Mini, хорошо подходят для использования на базовых ноутбуках.

Инструменты для локального развертывания LLM для программирования

Для удобного использования локальных LLM существуют различные инструменты:

- Ollama: Легкий инструмент с командной строкой, позволяющий запускать популярные модели кода с помощью простых команд.

- LM Studio: Удобный графический интерфейс для Windows и macOS, который упрощает управление моделями.

- Nut Studio: Идеально подходит для новичков, автоматически определяет оборудование и загружает совместимые модели.

- Llama.cpp: Ядро, поддерживающее множество локальных моделей, быстро работает и совместимо с различными платформами.

- text-generation-webui, Faraday.dev, local.ai: Прогрессивные платформы, предлагающие богатый графический интерфейс и API для разработчиков.

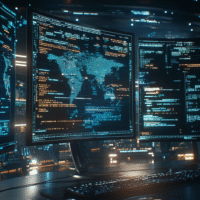

Что могут локальные LLM в программировании?

Локальные LLM способны на многое:

- Генерация функций, классов или целых модулей на основе естественного языка.

- Контекстуальное автозаполнение и предложения по продолжению кода.

- Проверка, отладка и объяснение фрагментов кода.

- Генерация документации и предложения по рефакторингу.

- Интеграция в IDE или отдельные редакторы, заменяющие облачные AI-помощники, не отправляя код внешним сервисам.

Заключение

К 2025 году локальные LLM для программирования достигли значительного прогресса, предлагая альтернативы исключительно облачным AI. Модели, такие как Code Llama 70B, DeepSeek-Coder, StarCoder2, Qwen 2.5 Coder и Phi-3 Mini, покрывают широкий спектр потребностей в оборудовании и задачах программирования. Инструменты, такие как Ollama, Nut Studio и LM Studio, помогают разработчикам эффективно использовать эти модели оффлайн. Если вы цените конфиденциальность, минимальные затраты или высокую производительность, локальные LLM становятся мощным дополнением к вашему инструментарию программиста.