Арена-Хард: новый подход к оценке возможностей чат-ботов на основе живых данных

В мире больших языковых моделей (LLM) разработчики и исследователи сталкиваются с вызовом точного измерения и сравнения способностей различных моделей чат-ботов. Традиционные бенчмарки для LLM были статичными и не отражали реального использования. Это привело к появлению системы “Арена-Хард”, разработанной LMSYS ORG, которая создает бенчмарки на основе живых данных, собранных с платформы, где пользователи непрерывно оценивают большие языковые модели.

Практические решения и ценность

Для реальной оценки LLM системы “Арена-Хард” предлагает:

- Непрерывное обновление прогнозов и эталонных результатов на основе новых данных и моделей.

- Включение разнообразных сравнений моделей для учета различных способностей и слабостей.

- Регулярную публикацию деталей о производительности бенчмарка, точности прогнозов и областях для улучшения.

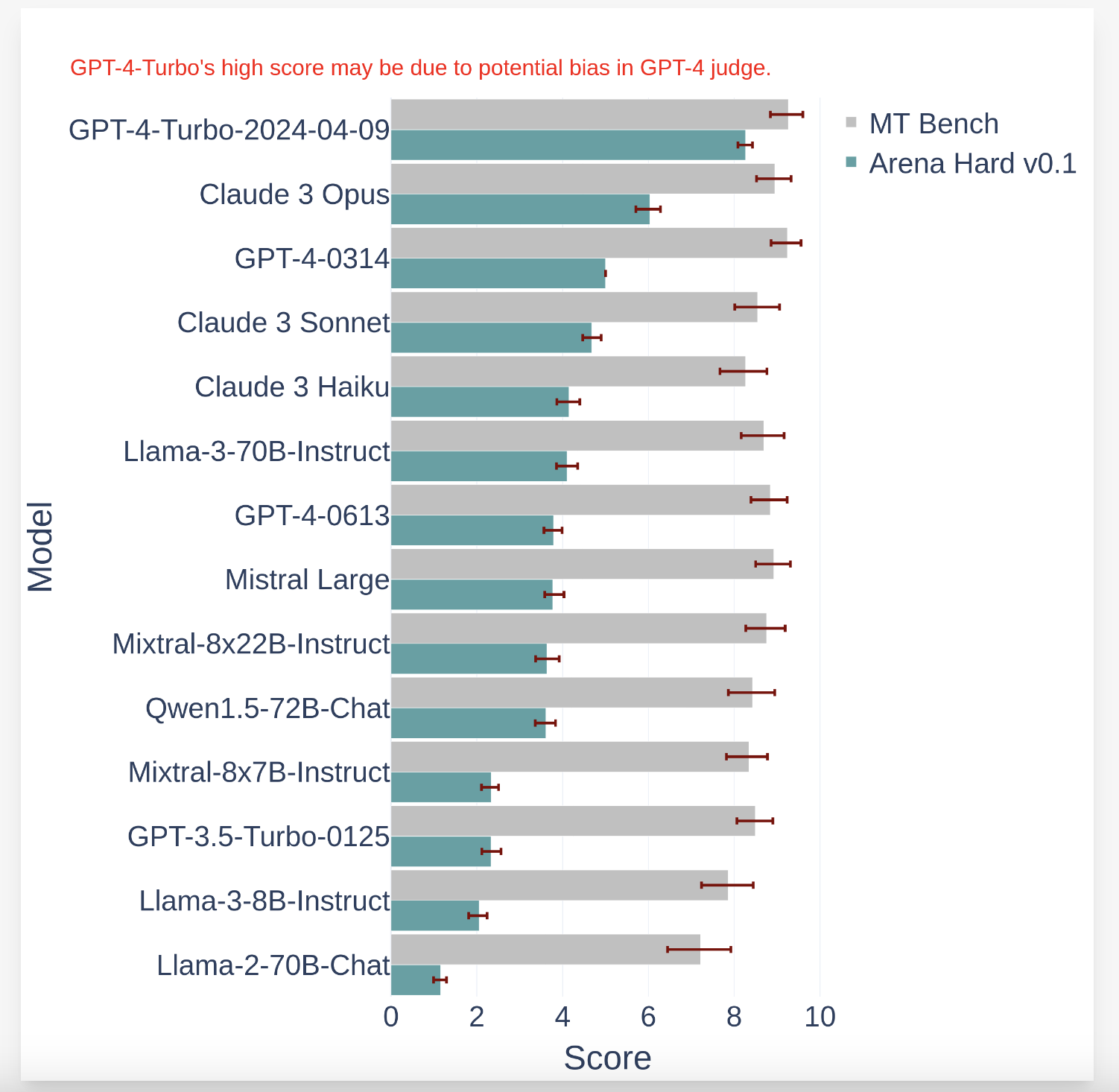

Система “Арена-Хард” показала значительно лучшую производительность по сравнению с существующими бенчмарками, демонстрируя высокую согласованность с предпочтениями людей и способность четко различать модели на основе их производительности.

Интеграция AI в бизнес

Если вы хотите использовать AI для развития своей компании, определите области применения автоматизации и ключевые показатели эффективности. Подберите подходящее решение и внедряйте AI постепенно, анализируя результаты и опыт для расширения автоматизации.

Узнайте, как AI может изменить ваши процессы с решениями от AI Lab aidone.ru.